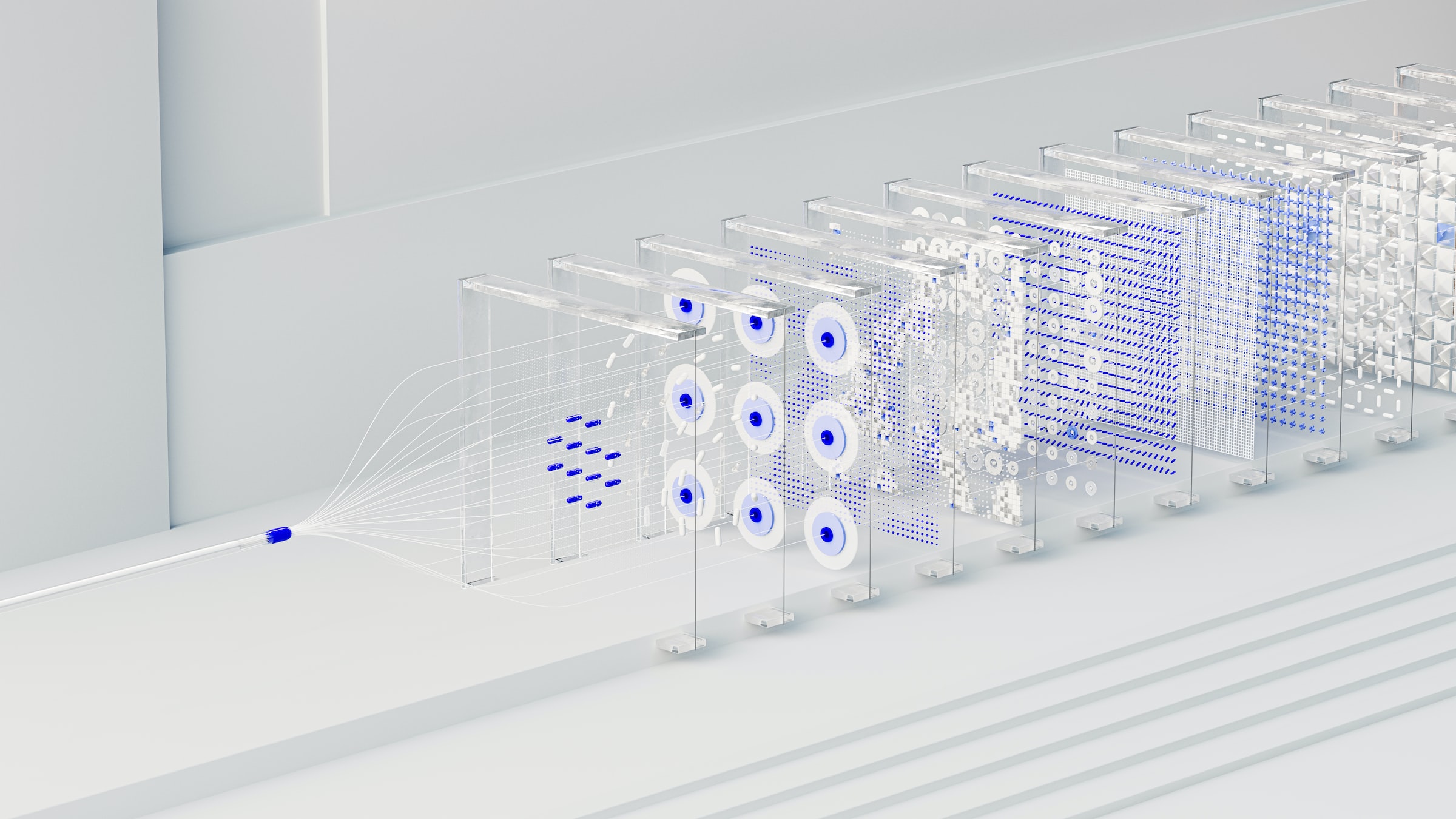

Artist: Christoph Schramm

Warum redet jeder über GPT?

Als Beratung sind wir ständig auf der Suche nach neuen Technologien und Methoden, um unseren Mandanten bestmöglich zu unterstützen. Unsere Arbeit, egal ob es sich um Kommunikation oder politischen Entscheidungen geht, dreht sich dabei zu weiten Teilen um Texte. Denn auch wenn sich im Leben inzwischen viel um Bilder und Videos dreht, bei Regulierung und kommunikativen Sondersituationen gilt immer noch der alte Spruch, „Wer schreibt, der bleibt“. Im Rahmen unserer Grundlagenarbeit verwenden wir einen guten Teil unserer Kapazität diese Texte zu finden, analysieren und die Ergebnisse ihrerseits zu verschriftlichen. Eine der aufregendsten technischen Entwicklungen im Bereich der Textarbeit sind sogenannte „Large Language Models“ (LLM), die in der Lage sind, menschenähnliche Sprache zu produzieren – vor allem aber auch zu verstehen.

Gerade letzteres erklärt die Popularität von ChatGPT, das OpenAI letzte Woche veröffentlicht hat. Die US-amerikanische Organisation beschäftigt sich mit der Erforschung künstlicher Intelligenz (KI) und hat in der Vergangenheit schon mehrere Standards-setzende KI-Modelle veröffentlicht. Das besondere an diesen Modellen ist, dass die Interaktion mit ihnen keine Programmierkenntnisse erfordert, sondern Aufgaben in ganz normaler Sprache gestellt werden kann, in sogenannten Prompts („Aufforderungen“). Gerade die letzte Iteration dieser Modelle, besagtes ChatGPT, macht die Interaktion besonders einfach, sie findet wie der Name verrät nämlich in einer Chat-Umgebung statt. Ob Gedichte zur Rolle der Geldwäscheprävention beim Weihnachtsmann oder kleine Computerprogramme, um nicht von Elon Musk gefeuert zu werden, ChatGPT schreibt diese auf Basis einer kurzen Nachricht.

Hype oder Hilfe?

Gedichte und Software-Code sind für den Kommunikations- oder Politikprofi zugegebenermaßen weniger interessant. Warum also sollte man sich mit den Large Language Models auseinandersetzen? Weil sie eben noch viel mehr können und damit die Geschwindigkeit, in der wir Informationen verarbeiten, drastisch erhöhen können. Und das nicht in einer Vision, sondern jetzt in diesem Moment und anders als viele andere KI-Tools mit sehr niedrigen Einstiegshürden.

Sie können, klug eingesetzt, bei Textarbeiten jede Menge Zeit sparen. Nicht nur das, anders als Menschen werden ihre „Augen“ nicht müde und sie können (ein entsprechendes Kreditkartenlimit vorausgesetzt) beliebig viele Texte gleichzeitig zusammenfassen, Zitate extrahieren oder Wissensfragen beantworten.

Ein kleines Experiment zeigt, was für angesprochene Textarbeit im Public Policy Bereich möglich ist:

Aufforderung an die KI: Extrahiere alle Zitate und ihre Autoren aus dieser Bundestag-Kurzmeldung und bewerte die Tonalität

Ergebnis:

“Gerade auf der Abschöpfungsseite brauchen wir ganz dringend ein Enddatum”, sagte Kerstin Andreae, Vorsitzende der Hauptgeschäftsführung beim Bundesverband der Energie- und Wasserwirtschaft.

“Jeder Automatismus zur Verlängerung per Verordnung ist zu vermeiden”, machte Wolfram Axthelm, Geschäftsführer beim Bundesverband WindEnergie, deutlich.

“Das ging bis zur Stornierung von Projekten”, so Simone Peter, Präsidentin des Bundesverbandes Erneuerbare Energien, über die Verunsicherung in der Branche durch den komplizierten Abschöpfungsmechanismus. Sie verlangte ebenfalls eine klare Befristung der Abschöpfung bis Juni 2023.

Die Tonalität der Zitate ist kritisch und besorgt. Die Sprecher der Energiebranche befürchten negative Auswirkungen auf ihre Investitionen und fordern klare Befristungen und Vermeidung von Automatismen bei der Regelung zur Abschöpfung von “Zufallsgewinnen”.

ChatGPT

Der Mehrwert…

Ist das eine 100%tige Auswertung? Nein. Hat es wenige Sekunden gedauert und hätte uns Arbeit abgenommen? Ja – und das mit einem minimalen Aufforderung. Feintuning von Prompt und Modell steigert die Qualität nachhaltig – ob die Qualitätssteigerung es durch MitarbeiterInnen verfassen zu lassen die Zeit wert ist, hängt dann sicherlich von der Priorität der Aufgabe ab. Muss man mit begrenzter Zeit 30 Stellungnahmen zu einem Gesetzesvorschlag sichten, können sich MitarbeiterInnen dann auf die Auswertung der Dokumente konzentrieren, die auf Basis einer ersten Zusammenfassung durch die KI als besonders relevant erachtet werden .

Zudem: MitarbeiterInnen sind ein knappes Gut, das betrifft auch die Politik- und Medienbranche. Deswegen sollten sie ihre Zeit optimalerweise auf Dinge verwenden, die den meisten Mehrwert bringen, und sich statt dem Zusammenfassen und Extrahieren von Informationen auf die Einordnung und Bewertung zu fokussieren.

Die KI-Modelle können hier also zu mehr Produktivität und mehr Zufriedenheit beitragen, während sie helfen, die Informationsflut in kleine Päckchen zu packen und zu priorisieren.

…und die Einschränkungen

Beschränkt sich Public Policy Arbeit also demnächst darauf, Arbeitsaufträge für die KI zu verwalten?

Ganz so ist es dann doch (noch) nicht. Denn obwohl die LLM-KI-Modelle Erstaunliches leisten, gibt es hier klare Limitierungen. Man mag es kaum glauben , aber technisch basieren alle Ausgaben der KI auf Vorhersagen des nächsten Tokens (~des nächsten Wortes). Aufgrund des großen Datensatzes, auf dem sie trainiert wurden, führt das zu den für uns erstmal menschlich wirkenden Ergebnissen. Auf den zweiten Blick erkennt man aber die Einschränkungen und Probleme, die es mit sich bringt.

- Überzeugtes Auftreten bei vollkommener Ahnungslosigkeit – den Wahlspruch manches Politikstudenten beherzigt auch die KI. Denn abseits einiger Einschränkungen von OpenAI wird jedes Ergebnis mit Überzeugung ausgegeben – auch wenn es absolut falsch ist. Denn das erkennt die Software nicht, sie ist sich nur sicher, die richtigen Wörter zurückgegeben zu haben. Auch Logik verstehen die KI-Modelle nicht, auch wenn es manchmal anders scheint

- Die Ergebnisse hängen stark von dem Prompt ab. Führt man kurze oder sehr allgemeine Prompts mehrfach aus, kommen teils sehr unterschiedliche Ergebnisse zurück. Will man GPT produktiv nutzen, muss man seine Prompts sehr ausführlich testen, um die Stabilität der Ergebnisse zu gewährleisten

- Gerade im Feld von Politik und Kommunikation ist Aktualität unglaublich wichtig. Die KI-Modelle „verstehen“ aber nur, was sie aus ihrem Trainingsdatensatz kennen. Im Falle von ChatGPT stammt dieser von 2021 – Zeitenwende, Energiekrise oder einen Mindestlohn von 12 € kennt das Modell nicht. Wenn das Modell erkennt, dass diese Frage zeitsensibel ist, weist es auch darauf hin. Wenn nicht, siehe Punkt 1.

- Auch wenn es im ersten Moment kontraintuitiv wirkt, aber LLMs sind nicht feinfühlig in ihrer Sprache. Zwar können sie durchaus einen Kontext berücksichtigen, aber Spezifika im Wording aus Sicht einer Organisation sind nicht ihre Stärke – zumindest wenn dieses sehr dynamisch ist.

- Wie bei jedem KI-Modell basieren die Ergebnisse auf den zugrundeliegenden Trainingsdaten. Sind diese verzerrt oder, was hier eher zutreffen dürfte, enthalten diese alle Vorurteile, die Menschen hervorbringen, so können auch die Ergebnisse diese Vorurteile oder Verzerrungen widerspiegeln. Auch die Frage, wie präsent bestimmte Sachverhalte in den Texten (Wikipedia!) der Trainingsdaten sind, beeinflusst, wie wahrscheinlich ihre Berücksichtigung in den Ergebnissen sind. Weniger ein Problem für einen großen Wirtschaftsverband, aber der kleine Fachverband sollte sich Gedanken machen.

Eine weitere Einschränkung, die insbesondere die Nutzung für die aktive Kommunikation betrifft, sind die Nutzungsrichtlinien von OpenAI. Sowohl das Erstellen von Kommunikationsmaterial als auch die Klassifizierung von User für das Targeting von politischer Werbung ist verboten. Das ist im Einzelfall zwar schwer zu identifizieren, wer aber die OpenAI-KI-Modelle regelmäßig im Einsatz hat, droht ggf. den Zugang zu verlieren, wenn es gegen die Richtlinien verstößt.

Praktische Tipps für die Nutzung

Stichwort regelmäßiger Einsatz: Die Chat-Funktion und auch der sogenannte „Playground“ für die GPT-Modelle sind nett zum, nun ja, „spielen“. Wer diese Modelle regelmäßig nutzen will, sollte aber die Schnittstellen nutzen, um tatsächlich skalieren zu können. Anders als die Probierfunktionen erfordert diese etwas technisches Know-How – und die Daten, mit denen man arbeiten möchte. Gerade letztere technisch wie rechtlich sauber bereitzustellen, dürfte für viele Organisationen herausfordernd sein. Nicht jede Organisation braucht jetzt aber Data Scientists um von dieser technischen Entwicklung zu profitieren. Schauen Sie mal auf unsere Tech Landscape (Neue Edition Anfang 2023!), einige der Dienstleister greifen schon darauf zurück – bei anderen kann man ruhig mal nachfragen, was hier die Pläne sind oder einfach Vorschläge machen. Erfahrungsgemäß werden User-Vorschläge wertgeschätzt, insbesondere wenn sie konkret („Wir würden gerne ChatGPT nutzen“ vs. „Wir würden gerne folgende Daten aus Texten extrahieren…“) sind.

Für allgemeinere Einsatzzwecke werden nach jeder GPT-Veröffentlichung Tools entwickelt, die mal mehr, mal weniger nützlich sind. Die Bandbreite reicht von kommerziellen Dienstleistern, die unter Verwendung von GPT die Schwellen beim Webdesign oder oder dem Erstellen von Marketing-Texten senken, bis zu Freeware, wie zum Beispiel ein Browser-Plugin, dass bei Google-Suchen nebenan die Ergebnisse von ChatGPT einblendet.

Wie setzen wir LLMs für uns ein? Es gibt bei uns keine Produkte, die 100% KI-basiert sind – die Qualität entspricht nicht unseren Ansprüchen. Wir nutzen KI aber durchaus, um unsere Arbeitsprozesse zu beschleunigen und unsere Kollegen auf die Aufgaben zu fokussieren, wo sie den meisten Mehrwert bringen (und die ehrlicherweise auch den meisten Spaß machen). Was heißt das? Da wir viel mit Texten arbeiten, nutzen wir LLMs primär zu Extrahierung von relevanten Inhalten und zur Zusammenfassung von Texten. Dazu nutzen wir allerdings nicht die Modelle, wie sie von OpenAI ausgeliefert werden, sondern feintunen diese auf Basis unserer bisherigen Arbeit. Dann helfen sie unseren Analysten aber, in dem sie Artikel o.ä. vorzusammenfassen, damit die Arbeitszeit zur politischen oder kommunikativen Einordnung verwendet werden kann – und nicht um grundlegende Inhalte zusammenzufassen. Natürlich muss diese KI-Zusammenfassung häufig noch mal angepasst werden. Nichtdestotrotz schafft sie eine erhebliche Zeitersparnis

LLMs sind dabei nicht die einzigen KI-Modelle die wir direkt oder via Tools einsetzen. Andere KI-Modelle nutzen wir z.B. im Bereich Klassifizierung und Signal Detection in unseren Monitorings. Anders als LLMs sind diese aber spezialisiert auf genau diese Use Cases.

Wir hoffen dieser Einblick konnte einen Einblick zum Trendthema GPT/LLM geben und wir darauf blicken bzw. diese für uns nutzen. Sie haben Fragen? Schreiben Sie uns oder kommentieren Sie unter unserem LinkedIn-Post!